近日,我院ACM协同创新团队的最新研究成果被深度学习领域顶级国际学术会议The International Conference on Learning Representations (ICLR)正式录用。

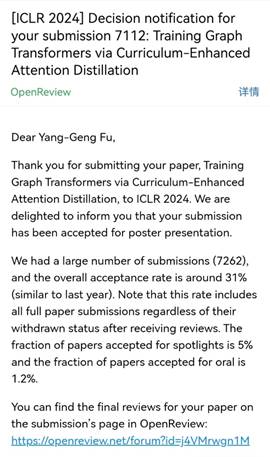

论文录用信息如下:

Yisong Huang, Jin Li, Xinlong Chen, Yang-Geng Fu*. "Training Graph Transformers via Curriculum-Enhanced Attention Distillation", accepted by ICLR 2024.

该研究成果由我院ACM团队21级硕士生黄益颂、20级硕士生李进、21级博士生陈鑫龙,在傅仰耿教授指导下完成。

Graph Transformers(GTs)在图级别任务上表现出色,但在节点分类任务中,尤其是在半监督设置下,GTs容易遭受过拟合的风险,训练GTs仍然是一项巨大的挑战。该论文提出了一个基于课程学习的注意力蒸馏方法,其中涉及到在Local Graph Transformer 和Global Graph Transformer之间进行注意力蒸馏,同时还引入了课外熵和top-k剪枝两项改进,约束了学生模型的行为,有效缓解了过拟合问题。此外,该方法通过课程学习动态调整学生模型的注意力分配,进一步提高了模型的性能和泛化能力。相比于现有的方法,该方法在同质图和异质图上取得了更优异的性能。

ICLR由深度学习领域的两位杰出学者Yoshua Bengio和Yann LeCun 牵头创办,自2013年开始每年举办一次,是全球深度学习领域公认的顶级学术盛会。ICLR 2024是其第十二届会议,计划于2024年5月7日至11日在奥地利维也纳召开。ICLR 2024共收到7262篇投稿,录用率约为31%。